NVIDIA 在 Hugging Face 上推出了 NV-Embed,这是一种先进的嵌入模型,在海量文本嵌入基准测试 (MTEB) 中名列前茅。该模型基于大型语言模型 (LLM) 架构,由于其独特的设计和训练方法,在各种任务中表现出显着改进。

绩效指标和成就

NV-Embed 在检索、重新排名和分类等多项任务中表现出色,在 MTEB 中获得了最高的整体排名。值得注意的性能指标包括:

-

- AmazonCounterfactualClassification (en):95.119% 准确率、79.215 平均准确率 (AP) 和 92.456 F1 分数。

- AmazonPolarityClassification:准确率为 97.143%,AP 为 95.286,F1 得分为 97.143。

- AmazonReviewsClassification (en):55.466% 准确率和 52.702 F1 得分。

- 阿瓜纳:MAP@1为44.879,MAP@10为60.146,MAP@100为60.533,MRR@1为0.000,Precision@1为44.879,Recall@1为44.879。

- Arxiv集群:V-Measure 为 53.764 (P2P) 和 49.589 (S2S)。

- AskUbuntuDupQuestions:MAP 为 67.499,MRR 为 80.778。

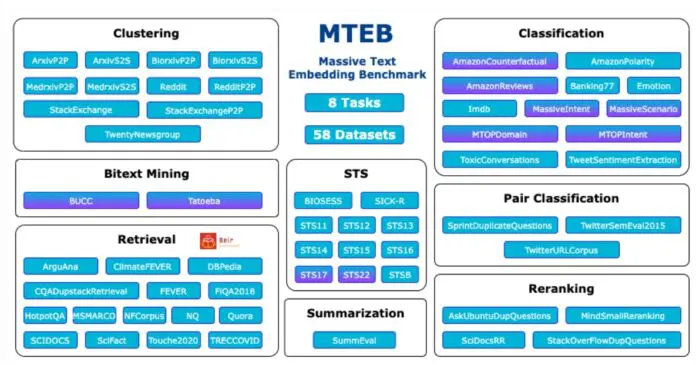

海量文本嵌入基准 (MTEB) 旨在解决传统文本嵌入评估的局限性,传统文本嵌入评估通常侧重于一组狭窄的数据集和任务。MTEB 提供了一个全面的基准测试框架,其中包括跨 58 个数据集和 112 种语言的 8 个嵌入任务,使其成为最广泛的基准测试之一。

该框架突出了自然语言嵌入的广泛应用,从聚类和主题表示到搜索系统和文本挖掘。

建筑和培训创新

NV-Embed 模型的成功很大程度上归功于其架构创新和先进的训练程序。虽然 NVIDIA 尚未透露有关模型配置、输出维度和参数计数的具体细节,但基于 LLM 的架构在其有效性中起着至关重要的作用。

该模型在各种任务中的出色表现表明,该模型使用了复杂的神经网络架构和利用大规模数据集的高级训练方法。

MTEB的挑战和见解

在 MTEB 框架中对 NV-Embed 的评估表明,没有一种文本嵌入方法在所有任务中都始终优于其他方法,这表明文本嵌入缺乏通用解决方案。该基准测试还强调了将生成语言模型或交叉编码器用于某些应用程序的不可行性,因为它们需要广泛的计算要求。

当前的文本嵌入模型通常以受约束的方式进行评估,专注于语义文本相似性 (STS) 和分类等任务,但未彻底测试可转移到其他任务(如搜索或聚类)的可转移性。

预处理和超参数设置的影响

预处理和超参数设置可能会显著影响模型性能,从而可能掩盖真正的性能改进。

MTEB 旨在清晰地了解各种嵌入任务的模型性能,提供文本嵌入模型状态的全面视图,包括开源模型和可通过 API 访问的模型。

多样化的模型性能

评估还发现,不同的模型在不同的任务中表现出色。例如,ST5 模型在分类任务中表现良好,而 MPNet 在聚类任务中与 ST5-XXL 等大型模型有效竞争。

GTR-XL 和 GTR-XXL 在配对分类任务中处于领先地位,MPNet 和 MiniLM 模型在重新排序任务中表现出强大的性能。SGPT-5.8B-msmarco 在检索任务方面表现出色,而 LaBSE 在双文本挖掘方面占主导地位,不同语言的性能各不相同。

许可和可访问性

NV-Embed 可在知识共享署名-非商业性使用 4.0 国际许可 (cc-by-nc-4.0) 下使用。这一许可选择反映了 NVIDIA 致力于让研究界能够访问其工作,同时限制商业用途。该模型在 Hugging Face 上的可用性进一步增强了研究人员和开发人员的可访问性。