Bing Chat,ChatGPT和其他类似的生成AI工具主要专注于理解文本内容并提供答案。但是,理解图片也非常有帮助,这就是Microsoft现在向其Bing Chat AI推出的内容。

在最近的一篇博客文章中,Microsoft宣布了Bing Chat的一项新功能,称为视觉搜索。使用视觉搜索,你可以上传图像或在 Web 上选择现有图像,必应将尝试理解它并在响应中使用该上下文。Microsoft的演示视频(嵌入在下面)展示了有人上传了一个 Web 表单的手绘模型,并要求 Bing 生成 HTML 和 CSS 代码以使其正常运行。

Microsoft在博客文章中解释说:“无论你是去一个新的城市度假,询问特定建筑的建筑,还是在家里试图根据冰箱里的东西想出午餐的想法,将图像上传到Bing Chat中,并用它来利用网络的知识来获得答案。

可以检测图像内容的软件并不是什么新鲜事。自 2017 年以来,Google Lens 已经能够识别照片中的人、动物、植物、地标和其他物体,其更有限的前身 Google Goggles 可以追溯到 2010 年。Microsoft使用的是 GPT-4 的图像检测功能,这与高级版 ChatGPT 使用的语言模型相同。但是,图像输入在 ChatGPT 中尚不可用,因此这是我们第一次看到该功能广泛使用。

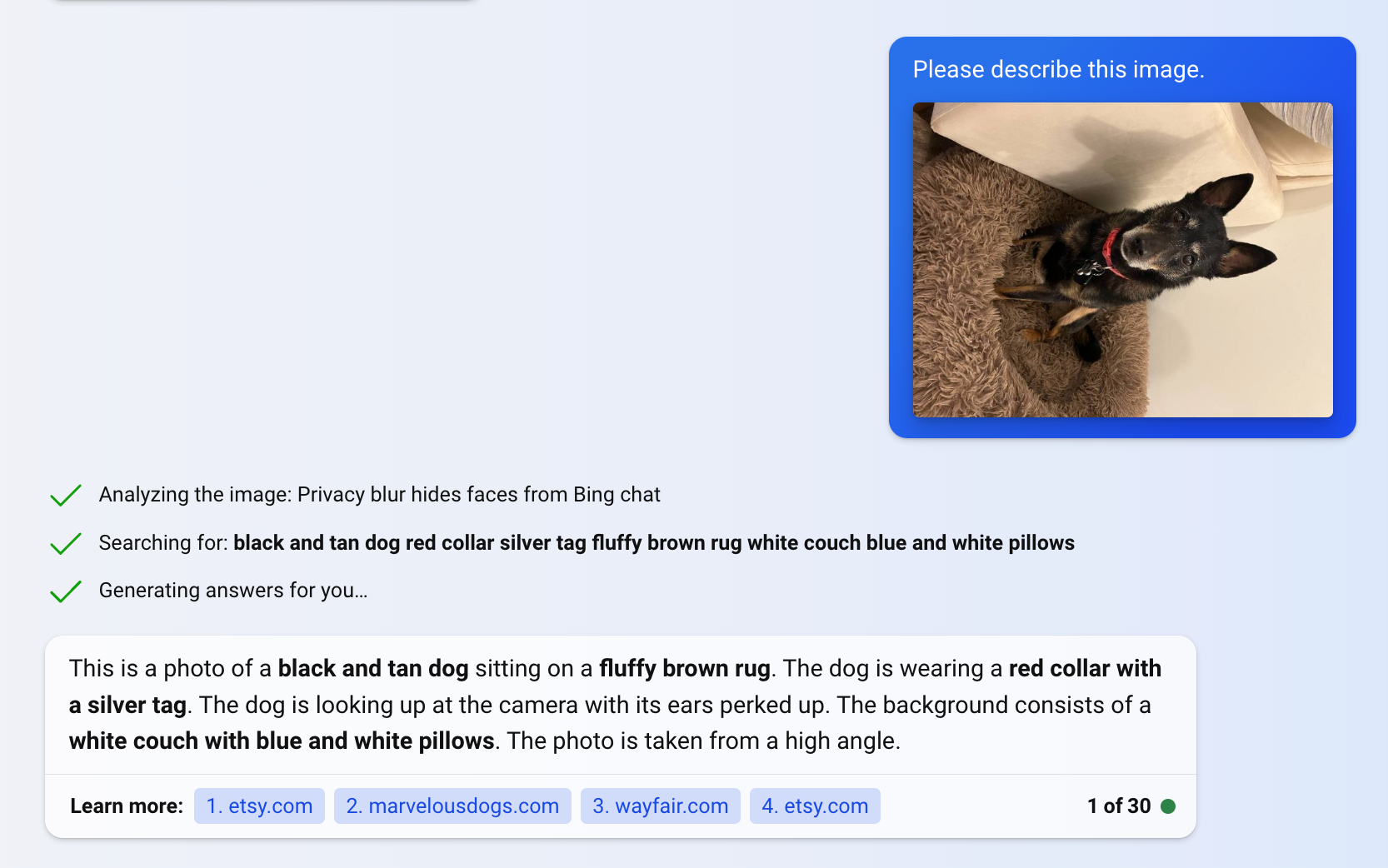

我用几张照片尝试了视觉搜索,结果令人印象深刻。要求必应描述图像会给你比从谷歌镜头得到更详细的回答。例如,上传我的狗的照片回复说:“这是一张黑色和棕褐色的狗坐在蓬松的棕色地毯上的照片。这只狗戴着带有银色标签的红色项圈。狗正抬头看着镜头,耳朵竖起来。背景包括一张白色沙发和蓝色和白色枕头。这张照片是从高角度拍摄的。它还正确地解释了图像是横向上传的。

您可以通过在 Microsoft Edge 中打开 Bing Chat(Microsoft在其他浏览器中仍会阻止它)并单击文本字段中的相机轮廓图标来试用该功能。